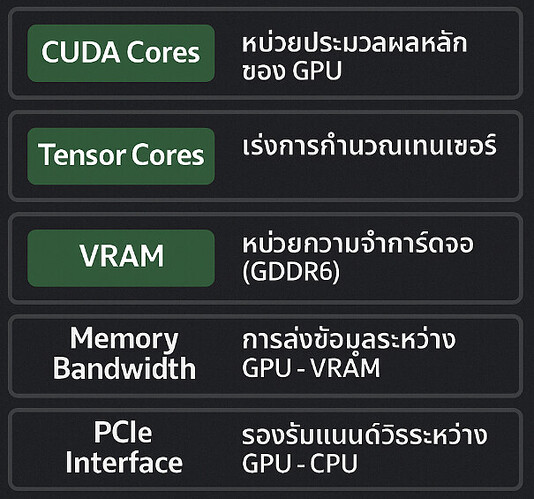

CUDA Cores CUDA Cores |

หน่วยคำนวณพื้นฐาน ใช้รันโค้ด ML อย่างเช่น TensorFlow / PyTorch เมื่อใช้ device=‘cuda’. ยิ่งมีมาก → ยิ่งทำงานแบบขนาน (parallel processing) ได้เร็ว |

Tensor Cores Tensor Cores |

หน่วยเฉพาะของ NVIDIA สำหรับเร่งความเร็ว Matrix Multiplication ซึ่งเป็นแกนหลักของ Neural Networks โดยเฉพาะใน FP16, BF16, FP8 → เร็วกว่าการใช้ CUDA Cores หลายเท่า |

VRAM (หน่วยความจำการ์ดจอ) VRAM (หน่วยความจำการ์ดจอ) |

ใช้โหลด โมเดล, batch data, weights, gradients ขณะฝึก ยิ่งเยอะ → ฝึกโมเดลใหญ่ขึ้นได้ เช่น GPT, LLaMA, Stable Diffusion |

Memory Bandwidth Memory Bandwidth |

ความเร็วในการส่งข้อมูลเข้า-ออก GPU (เช่น โหลด batch จาก CPU → GPU) → Bandwidth สูง ช่วยให้ GPU ไม่ต้องรอข้อมูล |

PCIe Interface PCIe Interface |

ช่องทางเชื่อมต่อการ์ดจอกับ CPU/Mainboard เช่น PCIe 3.0, 4.0 หรือ 5.0 → ถ้าต่ำเกินไป (เช่น 3.0 x4) อาจเป็นคอขวด โดยเฉพาะเมื่อใช้โมเดลหรือโหลด dataset ใหญ่ |

FP16 / FP8 / BF16 Performance (Tensor TFLOPS) FP16 / FP8 / BF16 Performance (Tensor TFLOPS) |

ประสิทธิภาพการประมวลผลเลขทศนิยมระดับต่ำที่นิยมใช้ใน AI (เช่น FP16) → ทำให้ฝึกโมเดลเร็วขึ้นหลายเท่าตัวถ้าใช้ Tensor Cores ได้เต็มที่ |

Driver + CUDA/cuDNN Support Driver + CUDA/cuDNN Support |

ใช้งานกับ Library เช่น PyTorch, TensorFlow, ONNX ได้หรือไม่ → การ์ดรุ่นใหม่อาจรองรับเวอร์ชันใหม่ที่ optimize ดีกว่า |

ECC Memory (เช่นใน RTX 5000 Ada) ECC Memory (เช่นใน RTX 5000 Ada) |

ลดโอกาสผิดพลาดของข้อมูลระหว่างประมวลผล (สำคัญกับงานวิจัย/การฝึกโมเดลขนาดใหญ่ที่ใช้เวลานาน) |

ตัวอย่างผลกระทบจริง

ตัวอย่างผลกระทบจริง รายการที่ “ไม่ค่อยมีผล” โดยตรง

รายการที่ “ไม่ค่อยมีผล” โดยตรง สรุป: รายการสำคัญจริง ๆ สำหรับ AI

สรุป: รายการสำคัญจริง ๆ สำหรับ AI